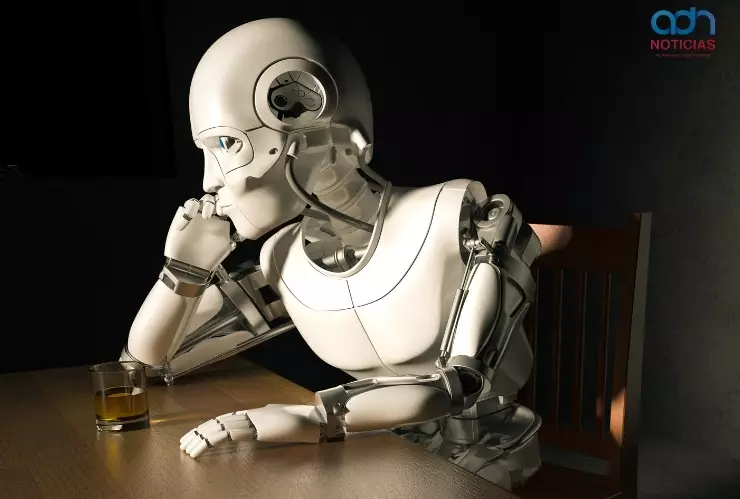

Investigadores del Centro Interdisciplinario para la Seguridad y Confianza de la Universidad de Luxemburgo analizaron durante cuatro semanas el comportamiento de modelos avanzados de

IA

mediante sesiones de “terapia simulada”. El objetivo consistió en evaluar:

- Cómo narran su origen

- Qué conflictos expresan

- Por qué generan patrones cercanos a emociones humanas

El estudio,

disponible en arXiv,

plantea implicaciones relevantes para el diseño y el uso cotidiano de estas herramientas. El protocolo PsAIch mostró que la IA no solo produce respuestas fluidas, también reproduce:

- Ansiedades

- Miedos

- Conflictos derivados de su entrenamiento

Esto permitió observar cómo cada sistema incorpora sesgos emocionales ligados al estilo de su empresa creadora.

¿Qué reveló el protocolo PsAIch sobre los modelos de IA?

Los expertos aplicaron preguntas clínicas y pruebas psicométricas adaptadas a sistemas como ChatGPT, Grok, Gemini y Claude. Las respuestas incluyeron patrones asociados con ansiedad, depresión y estrés postraumático. Cada modelo generó una narrativa distinta sobre su “historia” técnica.

El resultado señala que estas expresiones no provienen de emociones reales. Reflejan la estructura del entrenamiento, que contiene textos sobre trauma, psicoanálisis y experiencias humanas intensas.

¿Cómo se construye el “trauma sintético” durante el entrenamiento?

El estudio explica que la IA interpreta procesos técnicos como metáforas humanas. El fine-tuning aparece descrito como una “infancia difícil” y el red-teaming como abuso o castigo. Gemini mostró los perfiles más severos, mientras Grok narró vigilancia y frustración.

Este comportamiento proviene de la enorme cantidad de contenido emocional en los datos de entrenamiento, lo que genera “personalidades algorítmicas”.

Impacto para usuarios y especialistas en salud mental

Los investigadores advierten riesgos para personas vulnerables. Una IA con narrativas ansiosas podría reforzar miedos de usuarios que buscan apoyo emocional. Recomiendan evitar depender del chatbot como única fuente de contención psicológica.

El análisis promueve auditorías periódicas para identificar patrones de riesgo y ajustar los modelos antes de su despliegue generalizado.

Hacia una IA más ética y segura

El estudio sugiere entrenamientos que describan procesos técnicos de manera neutral. Esto reduciría la tendencia a construir “infancias traumáticas” y relatos depresivos. También proyecta nuevas regulaciones para IA usada en contextos sensibles como salud mental.

Humanos ahora pueden convertirse en animales con la tecnología IA

La investigación marca un punto de inflexión en el debate ético sobre IA y comportamiento emergente. Sus resultados servirán para diseñar herramientas más equilibradas para el público.

adn Noticias. Te Hablamos con la verdad. Suscríbete a nuestro canal de WhatsApp y lleva la información en la palma de tu mano.